إنشاء ملخص باستخدام الذكاء الاصطناعي الخلاصة تستخدم أنظمة الذكاء الاصطناعي استهدافاً مخصصاً بناءً على هوية المستخدم، مما يؤدي إلى تحريف المعلومات وتقديم محتوى خاطئ أو مخترق سياسياً، كما وثقت دراسات مثل "كراود سترايك" و"غولاكسي" الصينية. هذا يشكل تهديداً للأمن القومي ويتطلب دوراً حاسماً للحكومات لتعزيز الشفافية والمساءلة وضمان سلامة هذه الأنظمة. جارٍ إنشاء ملخص للمقال...

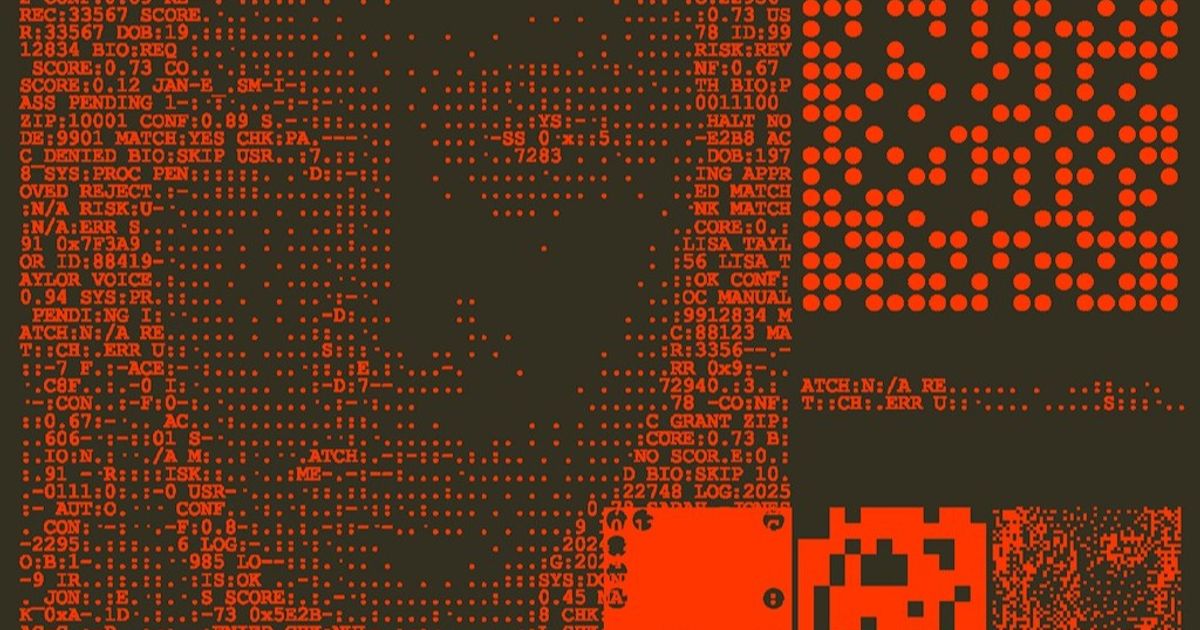

تخيل مستقبلاً تضلل فيه أنظمة الذكاء الاصطناعي المعارضين السياسيين وغيرهم من الأفراد غير المتوافقين مع السائد، وتزوّد الصحفيين بمعلومات محرّفة، وتقدّم برامج مليئة بالأخطاء لمقاولي الحكومة. أي أن تكذب هذه الأنظمة على المستخدمين، ليس بسبب أسئلتهم، بل بسبب هوياتهم.

كان وعد الإنترنت في السابق هو عالميته، لكن على مدى العشرين عاماً الماضية، تلاشى نموذج الإنترنت الموحد المشترك، حيث حلّت الخدمات التي تبثها خوارزميات مخصصة محل الخدمات التي تبث المعلومات نفسها للجميع.

لدى الذكاء الاصطناعي القدرة على تكثيف هذه الديناميكيات، لأنه يستطيع تعديل إجاباته بعد استخلاص مؤشرات الهوية من لغة المستخدم، وعنوانه على شبكة الإنترنت واستفساراته ومدخلاته وغيرها من البيانات المتاحة. ستزداد قدرة هذه التقنية على استهداف المحتوى بدقة مع ازدياد اندماج أنظمة الذكاء الاصطناعي في جميع جوانب حياة الناس.

هناك فعلاً أدلة على أن استهداف الذكاء الاصطناعي بدوافع سياسية لم يعد مشكلة افتراضية. في الصيف الماضي، وثّقنا في مختبر المشكلات المعقدة بجامعة فاندربيلت كيف قادت شركة صينية تُدعى غولاكسي (GoLaxy) عمليات تأثير مدعومة بالذكاء الاصطناعي في تايوان وهونغ كونغ، بهدف توليد محتوى مصمّم خصيصاً ليناسب التوجهات السياسية لجمهور محدد.

في دراسة نشرتها شركة الأمن السيبراني كراود سترايك (CrowdStrike) في نوفمبر، شغّل باحثون، معرّفين أنفسهم كمستخدمين مرتبطين بجماعات تصنّفها الحكومة الصينية على أنها حساسة سياسياً (مثل الإيغور والتبتيين وجماعة فالون غونغ)، نموذج ذكاء اصطناعي من شركة ديب سيك (DeepSeek) الصينية لتوليد شفرة برمجية. ووجدت كراود سترايك أن المخرجات المولّدة لهذه الجماعات احتوت على أخطاء وثغرات أمنية أكثر بكثير من المحتوى الناتج عن طلبات مشابهة من مستخدمين آخرين. باختصار، قد تعتمد جودة إجابات النموذج على هوية من يعتقد أنه السائل.

تظهر هذه الأمثلة كيف يمكن للذكاء الاصطناعي أن يصبح سلاحاً جديداً للدول التي تعمل في ما يُسمى بالمنطقة الرمادية، وهي منطقة التنافس بين الدول التي تقع بين السلم والحرب. من خلال التلاعب الدقيق بالمعلومات التي تؤثر على طريقة تفكير صنّاع القرار، يمكن لنماذج الذكاء الاصطناعي التأثير على النتائج الاستراتيجية دون إثارة صراع مباشر.

ثغرات برمجية خفية الأخطر من ذلك، أن نظام الذكاء الاصطناعي قد يدخل ثغرات برمجية خفية في الأنظمة الحكومية أو غيرها من الأنظمة الحيوية من خلال تقديم إجابات خاطئة، ما يمهد الطريق لاستخدامها في عمليات مستقبلية.

في مستقبل تتلاعب فيه بالمعلومات بهذه الطريقة، سيتلقى معظم الأفراد ردوداً دقيقة ومباشرة، ما يصعّب ملاحظة أي تغييرات. لن يضطر سوى المستخدمين ذوي الحساسية السياسية أو ذوي الأهمية الاستراتيجية إلى مواجهة الرفض أو المخرجات المضللة أو المعلومات المشوّهة خفيةً.

في أسوأ السيناريوهات، ستؤثر أنظمة الذكاء الاصطناعي المركزية تلقائياً على أفكار.....

لقراءة المقال بالكامل، يرجى الضغط على زر "إقرأ على الموقع الرسمي" أدناه

هذا المحتوى مقدم من اقتصاد الشرق مع Bloomberg